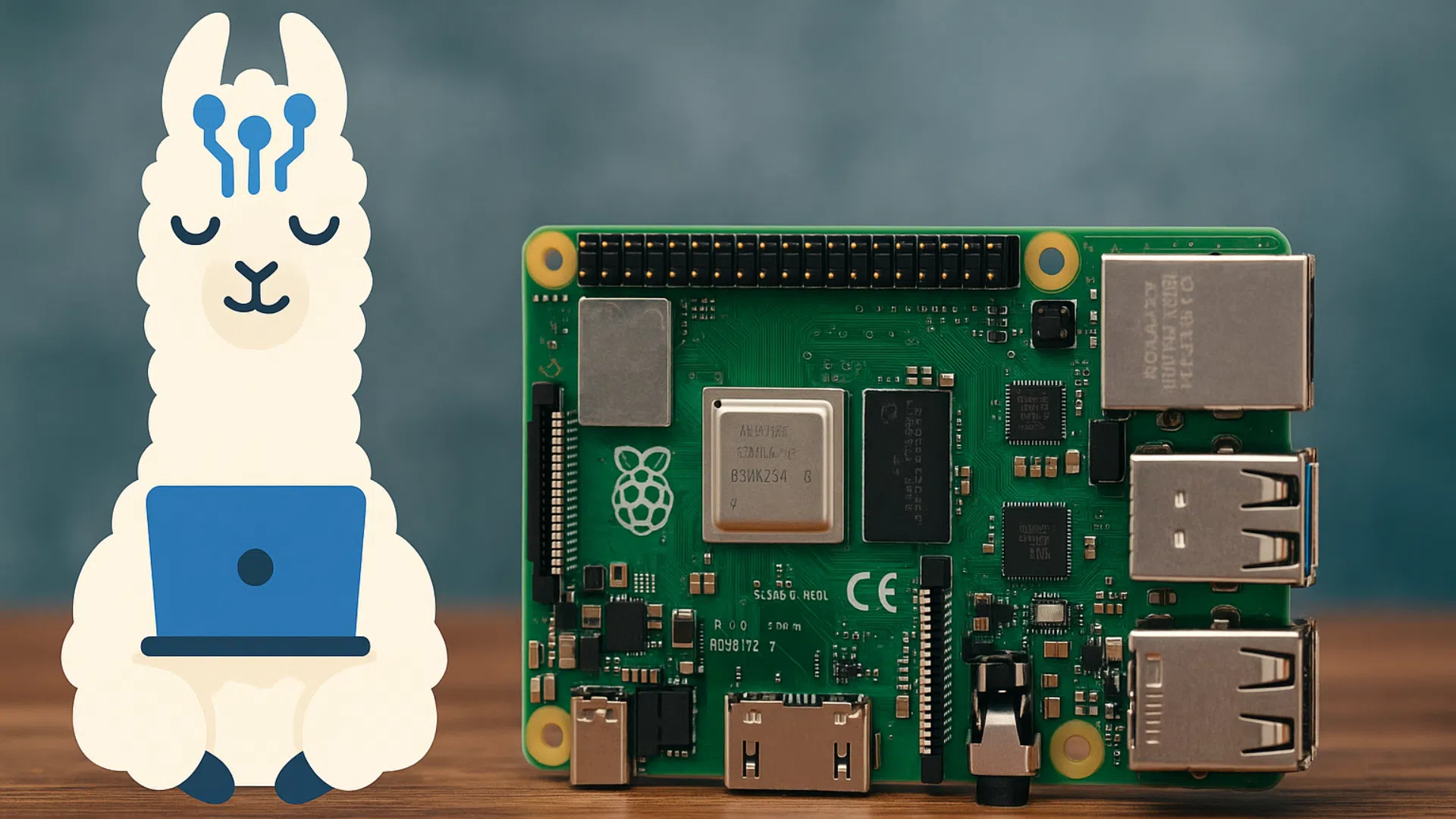

Ollama auf Raspberry Pi: Künstliche Intelligenz lokal bei Ihnen zu Hause

Einführung

Künstliche Intelligenz ist nicht mehr nur den digitalen Giganten vorbehalten. Heute ist es möglich, hochentwickelte Sprachmodelle direkt auszuführen auf lokaler EbeneSie können die Daten ohne Verbindung zu entfernten Servern speichern.

Genau das schlägt Ollamaeine Open-Source-Lösung, die es ermöglicht, KI-Modelle wie LLaMA 2, Mistral oder Vicuna auf einem persönlichen Computer.

Und die gute Nachricht? Mit ein wenig Kreativität kann man Ollama auf Raspberry Pi. Eine zugängliche Möglichkeit, diesen kleinen Computer in Mini-Labor für persönliche KI.

Was ist Ollama?

Ollama ist ein Laufzeitmaschine für Sprachmodelle (LLM) die den Einsatz und die Nutzung von KI-Modellen vor Ort erleichtert.

Seine Stärken :

- Lokale Ausführung → keine Notwendigkeit für eine Cloud.

- Kompatibilität mit mehreren Modellen LLaMA 2, Mistral, Falcon, Gemma, Vicuna...

- Einfache Schnittstelle : übersichtliche Befehlszeile und REST-API für Entwickler.

- Datenschutz : Ihre Daten verlassen Ihren Rechner nicht.

Zusammenfassend lässt sich sagen, dass Ollama den Zugang zu fortschrittlicher KI demokratisiert, indem es jedem ermöglicht, sie zu Hause zu installieren.

Warum wollen Sie Ollama auf Raspberry Pi?

1. Eine kostengünstige lokale KI

Ein Raspberry Pi 5 kostet viel weniger als ein High-End-PC. Auch wenn seine Ressourcen begrenzt sind, kann er als experimenteller KI-Server um Ollama zu entdecken.

2. Vertraulichkeit und Kontrolle

Mit Ollama bleibt alles lokal. Auf einem Raspberry Pi haben Sie eine autonome KI-Lösung die nicht von einem externen Dienst abhängig ist.

3. Erreichbarkeit

Ein Pi ist kompakt, leise und energiesparend. Er kann dauerhaft als persönlicher Miniserver laufen.

4. Um zu lernen und zu experimentieren

Das Ausführen von Ollama auf einem Pi ermöglicht ein besseres Verständnis der Funktionsweise von LLMs, ihrer Grenzen und ihrer Verwendung, ohne in eine teure Maschine investieren zu müssen.

Grenzen, die Sie im Auge behalten sollten

Seien wir realistisch: Der Raspberry Pi, selbst in der Version 5, hat nicht die Rohleistung eines PCs mit dedizierter Grafikkarte.

Hauptbeschränkungen :

- Begrenzter RAM 4 bis 8 GB (maximal 16 GB bei einigen Editionen). LLM-Modelle benötigen jedoch oft Dutzende von GB.

- Keine native GPU-Beschleunigung : Der Pi 5 verlässt sich vor allem auf seine ARM-CPU, was die Leistung einschränkt.

- Längere Reaktionszeit : Ein großes Modell (auch ein abgespecktes) auf Pi laufen zu lassen, führt zu einer hohen Latenz.

👉 Im Klartext: Der Raspberry Pi wird eine High-End-KI-Station nicht ersetzen. Aber um zu testen, ein schlankes Modell zu hosten oder pädagogische Projekte zu entwickeln, ist es perfekt.

Welche Verwendungszwecke hat Ollama auf Raspberry Pi?

Persönlicher Chatbot

Die Installation von Ollama auf Pi ermöglicht es, einen persönlicher Assistent die über einen Browser oder über API zugänglich ist.

Heimischer KI-Server

Man kann sich vorstellen, Ollama mit einem Hausautomationssystem (Home Assistant, Node-RED), um in natürlicher Sprache mit seinem vernetzten Zuhause zu interagieren.

Pädagogisches Labor

Ein Raspberry Pi mit Ollama ist ein hervorragendes Werkzeug, um KI lernen : Fine-Tuning von kleinen Vorlagen, Testen von Prompts, Integration in Apps.

Lokaler Server für Entwickler

Programmierer können den Pi als KI-BackendIn der Regel werden sie für die Erstellung von Texten, das Zusammenfassen von Notizen oder das Testen von LLM-Anwendungen verwendet.

Welche Modelle kann ich auf Raspberry Pi verwenden?

Angesichts der begrenzten Ressourcen des Pi ist es am besten, auf Modelle :

- Optimiert / quantifiziert (verkleinerte Größe, z. B. Q4 oder Q5).

- Kleine Modelle (<3B Parameter) wie:

- LLaMA 2-7B quantifiziert (Obergrenze).

- Mistral 7B erleichtert.

- TinyLlama oder GPT4All-J (besser geeignet).

👉 Ziel: ein Kompromiss zwischen Schnelligkeit und Qualität der Antworten.

Raspberry Pi 5: ein guter Kandidat für Ollama

Im Vergleich zu früheren Versionen ist der Pi 5 bietet einen echten Leistungssprung:

- Schnellere CPU (ARM Cortex-A76 2,4 GHz).

- Bis zu 8 GB RAM (bei einigen Deklinationen sogar noch mehr).

- Unterstützung von NVMe-SSDs, um große Modelle zu speichern.

Das öffnet die Tür für KI-Experimente realistisch, aber bescheiden.

Vor- und Nachteile

✅ Vorteile

- Lösung kostengünstig um Ollama zu testen.

- Kompakt und leise (ideal als Nebenserver).

- Ermöglicht das Lernen und Experimentieren mit KI vor Ort.

- Einhaltung der Datenschutz der Daten.

❌ Nachteile

- Begrenzte Leistung (hohe Latenz).

- Unterstützt keine sehr großen Modelle (>7B).

- Nicht für den intensiven professionellen Gebrauch geeignet.

Schlussfolgerung

Die Einrichtung vonOllama auf Raspberry Pi ist keine Entscheidung für rohe Leistung. Es ist keine Lösung, um einen PC mit Grafikprozessor zu ersetzen, sondern vielmehr eine zugängliches Tor zur lokalen IA.

Mit einem Raspberry Pi 5 und leichteren Modellen wird es möglich, seinen persönlicher Miniserver für künstliche Intelligenz : ein lokaler Chatbot, ein Assistent für die Hausautomatisierung oder ein Lernlabor.

👉 Wenn Sie neugierig, Maker oder EntwicklerOllama auf dem Raspberry Pi ist eine großartige Möglichkeit, KI auf andere Weise zu erforschen: mehr lokal, privater und zugänglicher.